“Pur avendo iniziato a percorrere una strada di semplificazione delle infrastrutture It, all’interno delle aziende siamo oggi a un livello di sviluppo tecnologico e di implementazione veramente complesso” dice Nicoletta Boldrini, giornalista di ZeroUno introducendo il Webinar “Verso l’It componibile: dall’iperconvergenza all’It programmabile come un codice”, organizzato da ZeroUno in partnership con Hpe e Intel: “Parliamo da tempo e frequentemente di agilità, flessibilità dei sistemi informativi, di modelli di digital business sicuramente molto allettanti a livello teorico, ma molto difficili da attuare soprattutto quando ci sono strati di legacy da considerare”.

I relatori del webinar, da sinistra: Nicoletta Boldrini, giornalista di ZeroUno, Stefano Mainetti, Co-direttore scientifico dell’Osservatorio Cloud e Ict as a service della School of Management del Politecnico di Milano, Giuseppe Cicchirillo, Product Manager – Data Center Infrastructure Hpe e Andrea Luiselli, Etg Enterprise Technology Specialist Intel

I sistemi iperconvergenti rappresentano uno dei tasselli di questa evoluzione: “Negli ultimi 8-10 mesi – ricorda Boldrini – il tema dell’iperconvergenza ha avuto un’impennata; la stessa Gartner afferma che si passa da un mercato pari sostanzialmente a 0 nel 2012, dato che prima del 2013 si parlava principalmente dei sistemi convergenti, a un giro d’affari nel 2019 stimato 5 miliardi di dollari. Il motivo di tale crescita va individuato prima di tutto nelle caratteristiche tecnologiche di questi sistemi: la ricerca di agilità e flessibilità del business digitale deve riflettersi in una dinamicità, ‘liquidità’ delle infrastrutture, ed è proprio qui che offrono la risposta migliore i sistemi iperconvergenti”, spiega la giornalista di ZeroUno, che prosegue: “Rispetto alla precedente generazione, questi sistemi hanno il plus di poter essere modellati, composti addirittura come mattoncini lego, costruiti su architetture standard x86 e facilmente gestibili”.

Indice degli argomenti

Il data center programmabile via software

La parola è quindi passata a Stefano Mainetti, Co-direttore scientifico dell’Osservatorio Cloud e Ict as a service della School of Management del Politecnico di Milano: “Tutti parlano di digital transformation come imperativo, ma non c’è una definizione univoca di queste parole e, soprattutto, il percorso da intraprendere non è banale; paragonandola al corpo umano, si tratta di una trasformazione completa del sistema nervoso”.

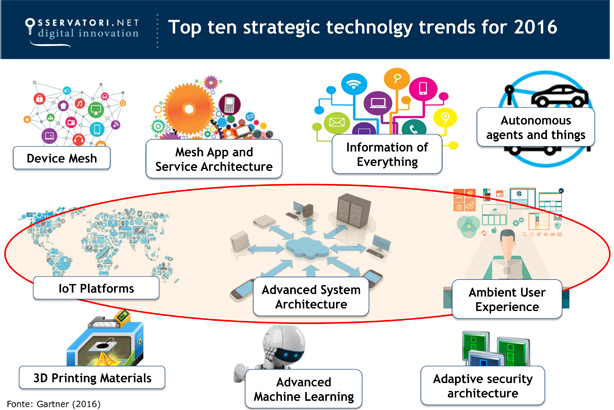

Figura 1 – Top ten strategic technolgy trends for 2016 – Fonte: Gartner (2016)

Figura 1 – Top ten strategic technolgy trends for 2016 – Fonte: Gartner (2016)

Nel mostrare la slide sui Top ten strategic technology trends for 2016 (Figura 1), Mainetti evidenzia come alcuni di questi (IoT Platforms, Advanced System Architecture, Ambient User Experience) abbiano un forte impatto sulle infrastrutture: “Se reagissimo a questi trend nel loro insieme nel modo in cui l’It ha fatto fino a qualche anno fa, ci troveremmo nella condizione di limitare questa trasformazione perché la nostra risposta sarebbe creare ulteriori silos o fare overprovisioning delle risorse. Ma è ovvio che oggi una risposta di questo tipo non è più perseguibile”, ricorda Mainetti. “L’offerta sta proprio andando verso una nuova tipologia di risposta. La prima è il cloud, con il paradigma del cloud pubblico che è sempre più interessante anche per workload mission critical, ma contestualmente i sistemi in house devono consentire di lavorare con asset interni sempre più agili, combinati con gli asset esterni.

Figura 2 – Il mercato Cloud in Italia – Fonte: Osservatorio Cloud & ICT as a Service (2015)

Figura 2 – Il mercato Cloud in Italia – Fonte: Osservatorio Cloud & ICT as a Service (2015)

Bisogna creare un sistema ibrido”. L’analista ricorda il trend evidenziato dai dati 2015 dell’Osservatorio stesso (figura 2): “Le imprese italiane stanno facendo investimenti importanti sulle infrastrutture abilitanti il cloud: su 1,5 miliardi di euro investiti nel cloud, due terzi sono stati spesi in queste infrastrutture. I sistemi iperconvergenti sono una componente importante di queste infrastrutture abilitanti il percorso verso l’hybrid It (figura 3): soluzioni flessibili, componibili, programmabili via software”.

Figura 3 – L’evoluzione infrasstrutturale – Fonte: Osservatorio Cloud & ICT as a Service (2015)

Figura 3 – L’evoluzione infrasstrutturale – Fonte: Osservatorio Cloud & ICT as a Service (2015)

Dai sistemi iperconvergenti a un data center programmabile come un software, ma come concretamente realizzarlo? “Bisogna pensare a uno strato intermedio – chiarisce Mainetti – che disaccoppia il provisioning delle risorse fisiche da quello delle risorse virtuali. Ma questo è possibile solo se all’interno dell’impresa si impostano processi basati su DevOps, dove dallo sviluppo alle operation viene definito un processo che non richiede più la gestione di infrastrutture fisiche; le infrastrutture iperconvergenti sono in grado di semplificare questo percorso, facilitando l’astrazione verso l’hybrid cloud”.

Figura 4 – Verso un Hybrid IT con infrastrutture componibili e programmabili come un codice. Quali sono le sfide che ancora dovete superare? – Poll lanciato durante la diretta

Figura 4 – Verso un Hybrid IT con infrastrutture componibili e programmabili come un codice. Quali sono le sfide che ancora dovete superare? – Poll lanciato durante la diretta

A dimostrazione che i percorsi evolutivi sono complessi, intervengono i dati del poll lanciato tra gli utenti che seguono il webinar (figura 4) dove, alla domanda “Verso un Hybrid IT con infrastrutture componibili e programmabili come un codice. Quali sono le sfide che ancora dovete superare?” il 72% dei rispondenti afferma di non avere ancora concluso percorsi di virtualizzazione e automazione, step basiliari del percorso.

Infrastrutture iperconvergenti: quale utilizzo

Gli interventi di Giuseppe Cicchirillo, Product Manager – Data Center Infrastructure Hpe e di Andrea Luiselli, Etg Enterprise Technology Specialist Intel, ci guidano nell’approfondimento tecnologico: “L’iperconvergenza per Hpe – spiega Cicchirillo – è uno step verso l’hybrid It (figura 5) ed è importante sottolineare che questi sistemi non hanno un utilizzo general purpose (figura 6), ma sono destinati a workload definiti come per esempio le enterprise application, grazie alla capacità di questi sistemi di garantire nativamente l’alta affidabilità e il giusto mix di performance e densità, in termini di occupazione di spazi del data center”.

Figura 6 – Esempi di workload per le enterprise application – Fonte: Hpe

Figura 6 – Esempi di workload per le enterprise application – Fonte: Hpe

L’offerta Hpe si sostanzia in due soluzioni (figura 7): “Hpe HC-250 focalizzato sulla densità computazionale e Hpe HC-380, appena introdotto. Per entrambi ci sono connettori specifici per i cloud pubblici; abbiamo poi un ulteriore livello di astrazione, Hpe Helion Open Stack, un vero e proprio portale di servizi che consente di gestire tutte le risorse (cloud compreso) indipendentemente dal tipo di sistema sottostante”.

Figura 7 – L’offerta di Hpe – Fonte: Hpe

Figura 7 – L’offerta di Hpe – Fonte: Hpe

“Da parte nostra – interviene Luiselli – ci stiamo impegnando a rimuovere tutte le barriere che potrebbero ostacolare questa evoluzione. In primo luogo abbiamo team di sviluppatori che lavorano insieme ai nostri partner, come Hpe, per sviluppare soluzioni congiuntamente. Un altro esempio è l’inserimento nel microprocessore di feature che sono alla base delle nuove esigenze delle imprese, come quelle di security, di gestione e orchestrazione; e ancora, facilitare l’implementazione creando una sorta di reference design guide cui si può fare riferimento quando si deve implementare un’infrastruttura ibrida”.

Figura 8- La tecnologia Intel Resource Director – Fonte: Intel

Figura 8- La tecnologia Intel Resource Director – Fonte: Intel

E proprio sul tema della gestione e orchestrazione delle risorse, Luiselli ricorda la recente introduzione della tecnologia Intel Resource Director presentata con il lancio dei processori Intel Xeon E5-2600 V4 (figura 8): “È una tecnologia che permette di orchestrare meglio il carico di lavoro: con i vecchi processori, per esempio, la virtual machine che prima veniva lanciata sull’hardware era quella che usava la maggior parte della cache di terzo livello, le virtual machine successive non erano quindi in grado di utilizzare la cache loro necessaria; questa tecnologia è invece in grado di definire una priorità nell’utilizzo della cache da parte delle virtual machine”.

Si è quindi aperto il dibattito sulle domande giunte in studio durante la diretta, focalizzate su 4 filoni principali: gestione e automazione dinamica del provisining; open standard e integrazione delle soluzioni all’interno del data center; timore di aumento della complessità del data center invece di una sua semplificazione; una serie di domande specifiche su diversi casi di applicabilità.

L’articolazione del dibattitto non è riassumibile in poche righe, consigliamo pertanto i nostri lettori di accedere alla piattaforma del Webinar dove è possibile leggere le domande poste, ascoltare le risposte nonché navigare tra le relazioni presentate e i numerosi documenti proposti a supporto della discussione.