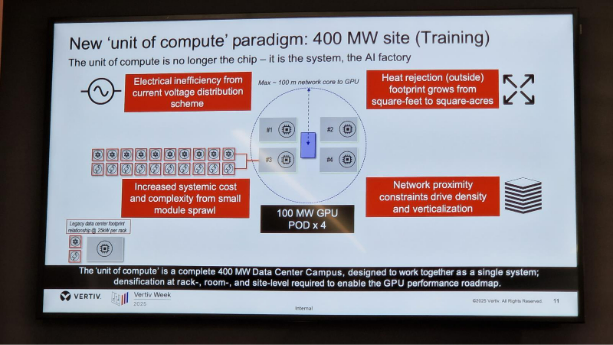

Un’AI factory è un impianto industriale di calcolo progettato per produrre in modo continuo modelli, token, inferenze e micro-decisioni. Si parla di factory perché l’infrastruttura non si limita a ospitare workload: deve sostenere una produzione ininterrotta di elaborazioni ad alta intensità, che richiede l’integrazione strutturale tra potenza elettrica, gestione termica, architettura dei rack, rete e orchestrazione. In questo modello i carichi possono aumentare di uno o due ordini di grandezza in pochi millisecondi: ogni variazione attraversa simultaneamente tutti i livelli dell’infrastruttura e ne modifica i parametri operativi, imponendo un coordinamento costante tra tutti i sottosistemi. È questa interdipendenza a segnare la distanza rispetto ai data center tradizionali.

Indice degli argomenti

Che differenza c’è tra un CED e un’AI factory

I CED sono stati progettati per gestire workload stabili, assorbimenti lineari e cicli tecnologici pluriennali: una logica che funziona finché densità, potenza e termica evolvono lentamente.

Le AI factory, invece, devono sostenere centinaia di kilowatt per rack, variazioni istantanee di assorbimento e roadmap dei chip serrate. Il che significa che non basta sovradimensionare: serve un’infrastruttura capace di adattarsi in tempo reale a carichi estremamente variabili, preservando continuità operativa e stabilità termica anche quando i cluster entrano ed escono dai regimi massimi nell’arco di pochi istanti.

Come si progetta un’Ai factory

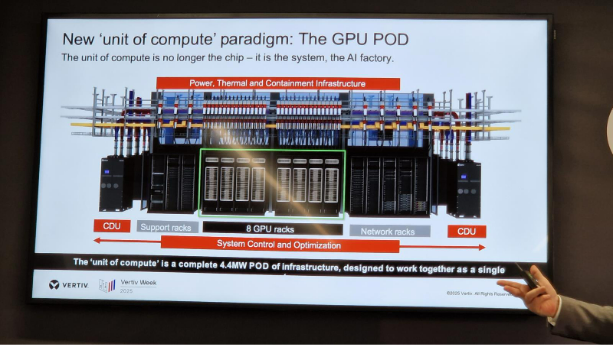

Di fronte a questa dinamica, la progettazione non può più essere distribuita per silos. Potenza, raffreddamento, rack e orchestrazione devono essere trattati come parti di un unico modello di calcolo, in cui ogni elemento influenza direttamente gli altri:

- la distribuzione elettrica deve anticipare picchi che possono saturare intere linee

- la termica deve reggere transizioni rapide senza degradare le prestazioni

- l’ingegneria dei rack deve garantire densità operative irraggiungibili per i CED tradizionali

- l’orchestrazione deve allocare risorse e workload in modo dinamico per mantenere la stabilità dei cluster

Ne consegue un nuovo modo di costruire le infrastrutture.

Verso una nuova ingegneria del data center

L’evoluzione del data center da sito di calcolo a fabbrica di token ha ricadute immediate sulla progettazione e sul modo in cui l’industria trasforma le infrastrutture. Un’evidenza emersa con chiarezza in quel di Tognana, quest’anno eletta come sede della Vertiv Week 2025, dove ingegneri, ricercatori e responsabili operativi europei hanno mostrato come l’AI impone un nuovo paradigma basato su visione condivisa, standard comuni, modularità avanzata e una diversa integrazione tra design e tecnologia. Tognana non è stata scelta a caso: è uno dei siti in cui Vertiv, azienda globale specializzata nelle infrastrutture per data center e ambienti mission critical progetta, assembla e prevalida i moduli che costituiscono la spina dorsale delle nuove AI factory.

“La velocità con cui stanno cambiando densità, potenza e termica oggi ha superato la capacità di adattamento dei data center tradizionali – ha spiegato Karsten Winther, president Europe, Middle East and Africa di Vertiv –, rendendo necessario un ripensamento profondo dell’ingegneria che governa la costruzione e l’evoluzione delle infrastrutture. La sfida del time-to-first-token si accompagna alla rapidità con cui le nuove generazioni di GPU si susseguono, riscrivendo i requisiti elettrici e termici dei data center. Questo rende impossibile progettare infrastrutture con cicli lunghi e statici. Il deployment è diventato un fattore vitale. Le AI factory richiedono approcci industriali basati su moduli prefabbricati, componenti off-site pretestati, digital twin per simulare carichi e condizioni operative, powertrain intelligenti e catene termiche integrate. In quanto veri e propri ecosistemi produttivi digitali, devono essere pensate per attraversare più generazioni di GPU, architetture e modelli di AI garantendo stabilità operativa anche in condizioni di variabilità estrema. È l’unico modo per gestire carichi da 100 a 600 kW per rack e aggiornare le facility alla velocità con cui cambia l’AI”.

Densità estreme e nuova fisica del raffreddamento

Nelle AI factory la densità è un parametro che può triplicare in un anno, trasformando ogni rack in un concentrato di potenza e calore che impone un ripensamento totale dell’ingegneria termica. Il salto dai tradizionali 10–40 kW per rack agli attuali 150–300 kW – con roadmap che guardano già verso i 500 kW e scenari da 1 MW – sta ridefinendo la fisica stessa dei data center.

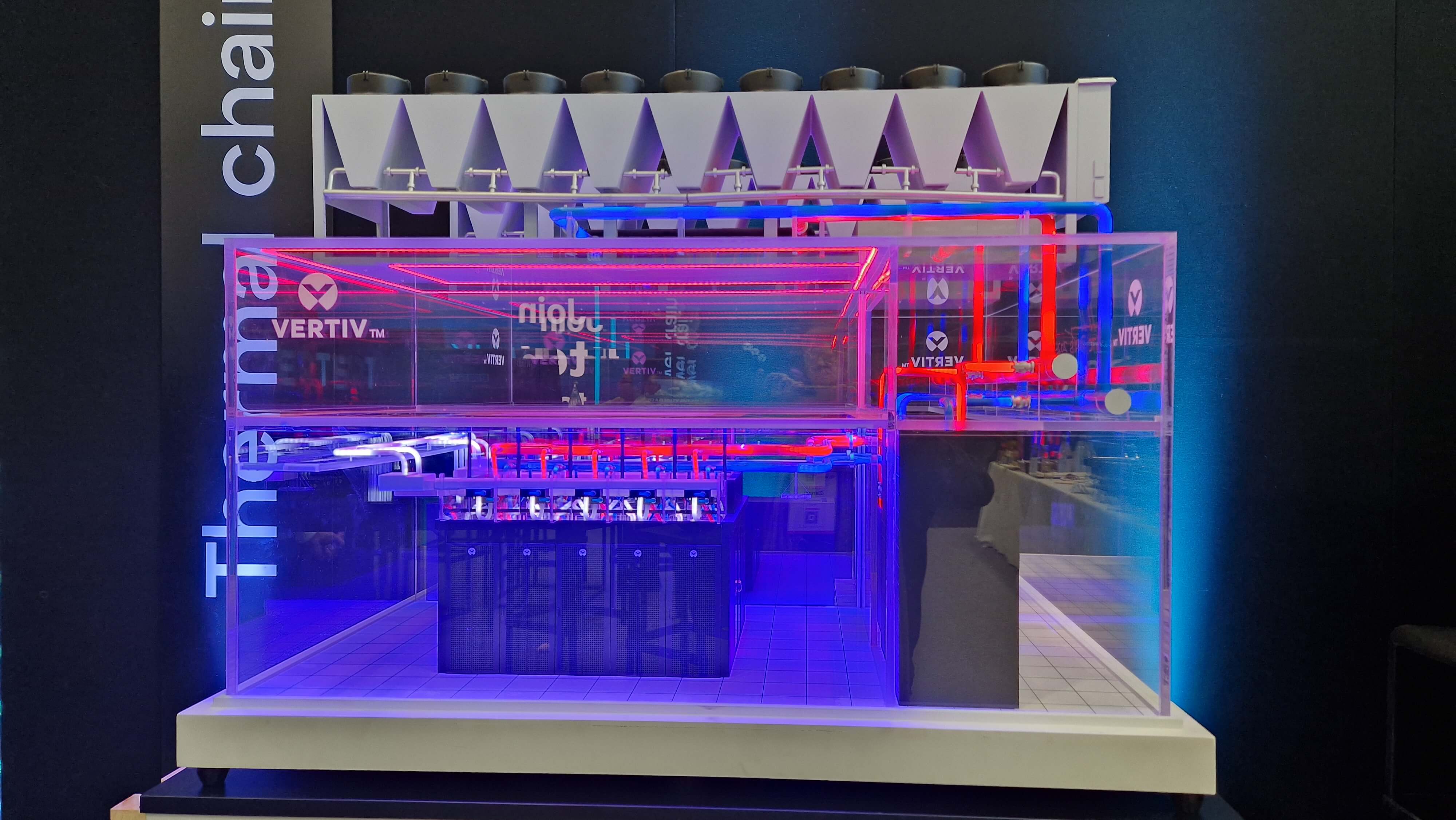

La gestione del calore non può più basarsi su logiche di raffreddamento ambientale o soluzioni puntuali: serve una thermal chain integrata end-to-end, un sistema continuo che parte dal chip e arriva fino allo scambio termico esterno. Cold plate e sistemi di liquid cooling a circuito chiuso diventano elementi strutturali della progettazione, insieme a manifold ad alta portata, loop secondari per la ridistribuzione del fluido, sensori di leak detection con tempi di risposta near real time e infrastrutture progettate per supportare variazioni istantanee dei carichi termici senza degradazione delle prestazioni. Il vincolo non è solo termico: è anche fisico.

«Anche il footprint cambia: il rapporto tra superficie tecnica e spazio utile si sta invertendo, con porzioni sempre più grandi di facility dedicate ai sistemi di potenza e di raffreddamento – ha spiegato Sam Bainborough, VP Thermal Business Emea di Vertiv –. È la fisica dell’infrastruttura a guidare il design: ogni watt assorbito, ogni grado da dissipare e ogni centimetro quadrato occupato diventa un vincolo da orchestrare all’interno di un sistema che deve mantenere continuità operativa anche sotto stress di calcolo estremo. In questo scenario la catena di raffreddamento diventa la spina dorsale che permette alle AI factory di sostenere densità estreme, transizioni improvvise e roadmap tecnologiche che cambiano più rapidamente dei cicli di costruzione tradizionali”.

Liquid cooling ingegnerizzato per le AI factory

Liquid cooling al centro della progettazione, con soluzioni che superano i limiti dell’aria e reintroducono l’idea di catene termiche fully-engineered. In questa direzione si colloca anche l’introduzione dei nuovi sistemi di immersione, progettati per gestire carichi da decine a centinaia di kilowatt per rack attraverso l’immersione completa dei server in liquidi dielettrici, spianando la strada a implementazioni più efficienti per AI e HPC.

“Con Vertiv CoolCenter Immersion mettiamo a frutto decenni di esperienza nel liquid cooling – ha aggiunto Bainborough – portando nel liquid cooling un approccio pienamente ingegnerizzato: vasche integrate, CDU dedicate, sensori distribuiti e pompe a velocità variabile lavorano come un unico sistema per gestire in sicurezza densità termiche estreme, dagli attuali 25 ai 240 kW per modulo. L’alimentazione ridondata e le pompe duplicate assicurano un’elevata disponibilità del raffreddamento, mentre i sensori di monitoraggio integrati, il touchscreen da 9 pollici e la connettività ai building management system (BMS) semplificano le operazioni e la visibilità sull’intero impianto. Il design del sistema abilita inoltre il recupero di calore, supportando strategie di gestione termica più efficienti e contribuendo agli obiettivi di efficienza energetica delle infrastrutture”.

Powertrain integrato: la continuità elettrica nell’era dei carichi dinamici

In parallelo, la trasformazione delle AI factory reingegnerizza anche l’intera la continuità dell’electric chain. I carichi dinamici delle GPU impongono a UPS, sistemi di accumulo e distribuzione in corrente continua di assorbire variazioni istantanee senza trasferire instabilità alla rete o ai carichi IT.

“La continuità elettrica è di fatto il sistema nervoso dell’AI factory – ha osservato Andrea Ferro, VP Power & IT Systems EMEA di Vertiv –. Stiamo passando da architetture tradizionali a modelli integrati in cui UPS intelligenti, battery system evoluti e distribuzioni a 50V e 800V DC vengono progettati e simulati digitalmente come un unico powertrain. Solo così possiamo garantire che, quando il carico AI raddoppia in pochi millisecondi, l’infrastruttura continui a erogare potenza stabile senza stressare la rete e senza degradare le prestazioni dei cluster”.

Questa integrazione non riguarda solo l’hardware. Anche il software diventa parte dell’equazione energetica: algoritmi, automazione e codice ottimizzato contribuiscono a mantenere stabile un’infrastruttura progettata per supportare l’AI.

«Standardizzazione, automazione software e ottimizzazione del codice applicativo sono leve decisive per ridurre il consumo energetico – ha proseguito Tiziano Durante, Cloud Region Lead Emea Microsoft – perché consentono di uniformare le architetture, semplificare la gestione e ottenere efficienze che sarebbe impossibile raggiungere con approcci frammentati. Nel nostro caso, progettare infrastrutture e servizi seguendo gli stessi principi in tutte le regioni ci permette non solo di accelerare il deployment, ma anche di ridurre l’impronta energetica del software stesso: un singolo ciclo macchina risparmiato si traduce in un risparmio tangibile su scala globale. È questa combinazione tra progettazione standardizzata, automazione intelligente e codice ottimizzato che rende sostenibile l’operatività delle AI factory e permette di governarne la complessità crescente”.

Sottostazioni, reti e bilanciamento: l’AI factory nella geografia dell’energia

Ma la transizione verso densità estreme non riguarda solo la microfisica dell’infrastruttura. La crescita delle AI factory sta modificando anche la relazione tra data center e sistema energetico, trasformandoli in nodi che interagiscono direttamente con reti, sottostazioni e capacità di bilanciamento nazionale. Le AI factory non sono più semplici utilizzatrici di energia: diventano elementi infrastrutturali che incidono sul dimensionamento delle sottostazioni, sulla capacità delle reti energetiche, sui tempi di connessione e sulla stabilità dei sistemi elettrici. In diversi Paesi europei i grandi operatori stanno già realizzando sottostazioni proprietarie, non solo per garantire la disponibilità di potenza necessaria ai workload di AI, ma anche per contribuire alla resilienza locale delle reti. È un cambio di ruolo che trasforma il data center in un attore del sistema energetico e non più solo in un punto di consumo.

«L’accelerazione dell’AI è arrivata più in fretta di quanto le infrastrutture nazionali fossero pronte a gestire – ha evidenziato Emmanuel Becker, CEO di Mediterra Datacenters –. Oggi ci troviamo in alcune aree d’Europa a costruire sottostazioni che non servono solo ad alimentare i nostri campus, ma a stabilizzare la rete circostante. In altri mercati veniamo coinvolti direttamente dai TSO perché i grandi data center sono diventati elementi del bilanciamento energetico: possiamo assorbire, ridurre o modulare i carichi per sostenere l’integrazione delle rinnovabili. È una trasformazione che lega tecnologia, energia e territorio in un unico ecosistema operativo”.

Come ha sottolineato il manager, il nodo da sciogliere non è trovare energia, ma trovare un sistema in grado di portarla dove serve, quando serve. Molti territori producono energia rinnovabile in eccesso che però non può essere trasferita efficacemente verso i poli digitali del Nord.

“Ecco perché parliamo sempre più spesso di comunità energetiche industriali – ha aggiunto Becker –: modelli in cui si produce localmente, si consuma localmente e si crea un legame diretto tra energia e capacità computazionale. Significa trasformare energia rinnovabile in potena digitale sul territorio, ridurre le perdite di rete, stabilizzare i flussi e restituire calore, servizi o capacità di controllo al tessuto produttivo circostante. È un approccio che permette di costruire poli digitali in aree oggi periferiche, valorizzare la generazione rinnovabile distribuita e ridurre la dipendenza dalle grandi dorsali di trasmissione. In Italia questo può diventare un acceleratore decisivo per riequilibrare la geografia del digitale, evitando la concentrazione in poche regioni e favorendo la nascita di nuovi distretti industriali ad alta intensità tecnologica”.

Connettività e latenza: la fibra come terzo vincolo fisico dell’AI factory

Se potenza e termica rappresentano i vincoli più visibili delle AI factory, la connettività è il terzo asse strutturale che sta ridefinendo la geografia e l’economia dei nuovi data center. L’AI non è soltanto una questione di watt e chilowatt: è una questione di fibra. La capacità delle dorsali, la distanza dai punti di atterraggio dei cavi sottomarini, la qualità delle tratte terrestri e i livelli di latenza determinano infatti dove un’AI factory può nascere, quali servizi può erogare e con quali costi operativi. Perché oggi la distanza fisica è tornata a essere un parametro ingegneristico: i centri destinati al training dei modelli possono trovarsi lontano dagli hub urbani, ma le architetture orientate all’inferenza hanno bisogno di risposte che non superino pochi millisecondi. Questo crea una distinzione infrastrutturale tra i campus da centinaia di megawatt, che richiedono collegamenti ad altissima capacità, e le strutture distribuite più vicine ai poli di consumo digitale.

«Il tema non è solo la quantità di fibra disponibile, ma il costo e la complessità di portarla dove serve – ha osservato Becker -. La connettività è già oggi una delle voci più onerose dei campus ad alta densità: costruire un data center da 300 MW in un’area non servita da tratte adeguate può significare investire più nella fibra che nell’infrastruttura stessa. Le regioni attraversate dai nuovi corridoi digitali diventano punti privilegiati per ospitare AI factory con ambizioni globali. Latenza, availability della fibra e capacità di traffico sono vincoli fisici che possono abilitare o impedire l’esistenza stessa di una facility. È un cambio di prospettiva che sposta il data center dal dominio dell’IT a quello delle infrastrutture critiche territoriali».

Geografia computazionale e nuove competenze per le AI factory

Questa trasformazione ridisegna anche la geografia computazionale dell’AI con una catena del valore che diventa multilivello: grandi motori centrali dedicati al training, architetture distribuite per l’AI agentica e nodi di prossimità in cui l’intelligenza si avvicina ai processi fisici. È il passaggio dai data center come punti di calcolo alle AI factory come infrastrutture territoriali che orchestrano, su scala diversa, training, inferenza e servizi digitali di nuova generazione.

In questo scenario, le persone diventano un vincolo tanto critico quanto l’energia o la fibra. La crescita delle AI factory richiede nuove competenze lungo tutta la catena: progettisti in grado di lavorare con digital twin e reference design modulari, tecnici specializzati in power e liquid cooling, operatori di impianto, profili provenienti da settori come navale, oil & gas, utility.

“Il settore dei data center impiega già oltre 17.000 persone in Italia e più di 2,3 milioni nel mondo – ha ricordato Alessandro Talotta, Managing Director Italy di Digital Realty – ma la domanda di skill sta esplodendo. Stiamo entrando in un’epoca in cui non servono solo ingegneri: servono elettricisti, tecnici termici, specialisti di automazione, project manager, esperti di codifica del software, figure con competenze ibride che sappiano leggere impianti complessi e, allo stesso tempo, lavorare in ecosistemi digitali sempre più automatizzati. Per sostenere questa crescita dobbiamo aprire i siti alle scuole e alle università, mostrare come funziona davvero un data center, far capire che non si tratta di scatole chiuse ma di fabbriche di servizi digitali, con percorsi di carriera stabili, qualificati e con una domanda crescente per i prossimi decenni. Questo settore ha bisogno di talenti molto più rapidamente di quanto il mercato oggi sia in grado di formarli”.