I neocloud provider sono nati per risolvere un problema immediato: la scarsità globale di GPU. In pochi mesi si sono imposti come alternativa rapida e conveniente agli hyperscaler, offrendo capacità di calcolo ad alta intensità a prezzi più bassi e con tempi di provisioning molto più rapidi. Ma ora arriva il test vero: dimostrare di poter diventare sostenibili nel medio periodo.

Secondo un nuovo report di McKinsey, il rischio è quello di ripetere le dinamiche viste nel Cloud 1.0, quando molti provider nativi furono assorbiti o marginalizzati dai grandi player del settore .

Indice degli argomenti

Neocloud e BMaaS: la carta d’identità

I neocloud sono provider nati per offrire GPU-as-a-Service e, in modo particolare, bare-metal-as-a-service (BMaaS). A differenza dello IaaS, il BMaaS mette a disposizione hardware fisico dedicato, senza livelli di virtualizzazione overhead.

In sostanza, il BMaaS è un modello in cui un’azienda noleggia server fisici “nudi”, privi di hypervisor e di strati software tipici del cloud. Il cliente ottiene accesso diretto all’hardware, quindi:

- massime prestazioni, senza la latenza introdotta dal layer di virtualizzazione

- controllo totale su configurazioni, stack software e ottimizzazioni

- assenza di condivisione delle risorse con altri tenant, quindi performance costanti

- possibilità di creare cluster personalizzati per training e inferenza AI ad alta intensità

Per i workload AI su larga scala, questo modello offre una combinazione di velocità e prevedibilità spesso superiore rispetto ai cloud tradizionali.

Tra i neocloud più noti a livello globale ci sono CoreWeave, Lambda, Crusoe, Voltage Park, RunPod, Hyperstack e altri player emergenti soprattutto negli Stati Uniti. Molti hanno ottenuto capitali significativi proprio grazie alla domanda crescente di capacità AI.

Perché gli investitori ci credono ancora

Nonostante il modello sia ad alta intensità di capitale, McKinsey individua quattro motivi chiave che continuano ad attirare investimenti:

- BMaaS come punto di ingresso, non come obiettivo finale: la vera redditività si gioca nell’evoluzione verso servizi AI-native (orchestrazione, inference fabric, developer tools, verticalizzazioni). Questi livelli aggiuntivi permetteranno di aumentare la fidelizzazione dei clienti, migliorare la retention e ottenere economie simili a quelle delle software company, consentendo ai neocloud di raggiungere multipli comparabili al software-as-a-service

- Domanda di calcolo in continua esplosione. Il fabbisogno di capacità per training e inference continuerà a crescere rapidamente (si stima possa raggiungere circa 200 gigawatt entro il 2030). E l’offerta infrastrutturale rappresenta il principale collo di bottiglia.

- Valore residuo delle GPU, che possono essere riutilizzate in contesti enterprise noleggiandole a tariffe più basse alle imprese che non hanno bisogno dell’ultima generazione di chip.

- Ruolo dei produttori di chip, che con allocazioni preferenziali e supporti finanziari offrono una sorta di “paracadute”.

Economics fragili: prezzi in calo, margini bassi e ricavi concentrati

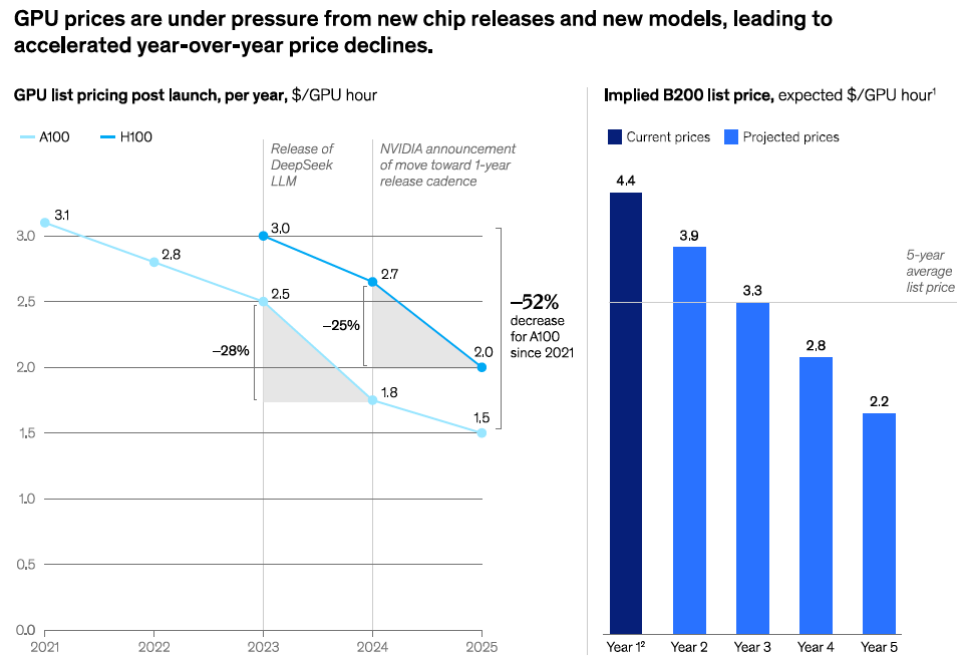

La sostenibilità economica dei neocloud resta il punto più critico. Il ciclo di aggiornamento rapidissimo dei chip porta a una continua erosione del prezzo della GPU-hour, come illustrato nel grafico in basso: entro 4–5 anni il prezzo medio orario di una GPU può dimezzarsi.

Questo obbliga i provider a: recuperare gli investimenti molto rapidamente; reinvestire in nuove generazioni di GPU per restare competitivi; gestire margini che si comprimono ulteriormente quando il tasso di utilizzo cala sotto l’80%

Come evidenziato nel report McKinsey, il BMaaS ha margini lordi un po’ deboli (55–65% prima dell’ammortamento). Con questi margini lordi e con il livello di intensità di capitale richiesto per acquistare GPU e CPU e attivare i server, il modello BMaaS è molto vulnerabile alle oscillazioni di prezzo e di utilizzo. «Se il prezzo di noleggio delle GPU cala anche di poco, o se il tasso di utilizzo scende sotto l’80%, i ritorni si azzerano» spiegano gli analisti

A ciò si aggiunge una forte concentrazione dei ricavi: per alcuni provider più del 50% deriva da uno o due clienti, spesso hyperscaler che acquistano capacità in blocco per esigenze di overflow.

Il paradosso strategico (e le possibili evoluzioni)

Per aumentare margini e customer retention, i neocloud dovrebbero salire “verso piattaforme e servizi AI-native. Ma questo li porterebbe a competere frontalmente con gli hyperscaler, ovvero gli stessi attori che oggi garantiscono loro una quota significativa del fatturato tramite contratti di capacity offload.

McKinsey individua tre possibili sviluppi per la sopravvivenza del settore:

- Specializzazione su nicchie difendibili. Mercati aggredibili potrebbero essere il computing sovrano, ambienti ultra-regolamentati, inferenze a latenza estremamente bassa, cluster HPC su misura. Si tratta di ambiti dove gli hyperscaler sono meno efficaci (o meno benvenuti).

- Puntare sulle start-up AI e crescere con loro. I neocloud possono diventare partner fin dall’inizio per le nuove piattaforme AI-native, costruendo una relazione che permane mentre scalano verso consumi massivi.

- Consolidamento. Acquisizioni da parte di hyperscaler, telco e governi, oppure uscita dal mercato non appena la disponibilità di GPU torna ad allinearsi alla domanda.

Le considerazioni per i CIO

Per i CIO, i neocloud rappresentano un’opzione tattica per ottenere GPU in tempi rapidi. Ma non è detto che possa diventare qualcosa di più strategico. La valutazione di se e quando adottarli ha a che fare con 3 trade off:

- Costo vs rischio (e continuità operativa). L’attrattiva principale dei neocloud è evidente: possono offrire capacità di calcolo avanzata a prezzi decisamente inferiori rispetto agli hyperscaler, soprattutto per training intensivi o progetti sperimentali che richiedono cluster dedicati per periodi limitati. Tuttavia, questa convenienza va bilanciata con una valutazione realistica del rischio. I margini ridotti, l’elevata concentrazione dei ricavi su pochi clienti e la necessità continua di reinvestire in nuove generazioni di GPU li rendono provider più vulnerabili agli sbalzi di mercato. Per i CIO, la domanda da porsi è semplice: il risparmio immediato vale il rischio di un fornitore meno stabile nel medio periodo? La risposta varia in base alla criticità del workload.

- Flessibilità tecnica vs maturità dello stack. Il modello bare-metal-as-a-service offre una libertà quasi totale: configurazioni personalizzate, accesso diretto all’hardware, assenza di virtualizzazione e prestazioni prevedibili. Questo approccio è ideale per team data science che vogliono spremere ogni watt di performance. Ma la flessibilità ha un prezzo. Rispetto agli hyperscaler, i neocloud offrono oggi un ecosistema software decisamente più limitato: strumenti MLOps meno maturi, servizi gestiti ridotti, integrazioni meno estese. In pratica, ciò che si guadagna in controllo si può perdere in semplicità operativa.

Multicloud evoluto vs lock-in infrastrutturale. L’ingresso dei neocloud nel portafoglio fornitori può diventare un’opportunità per rendere davvero dinamica la propria strategia multicloud. Distribuire i workload tra hyperscaler e provider specializzati aiuta a controllare i costi, ridurre il rischio di lock-in e aumentare la resilienza complessiva. Tuttavia, questa apertura porta con sé complessità nuove: orchestrare flussi dati tra ambienti diversi, gestire pipeline AI su hardware eterogeneo, garantire portabilità tra cluster che non hanno gli stessi livelli di astrazione. È una scelta che richiede maturità architetturale e governance solida.