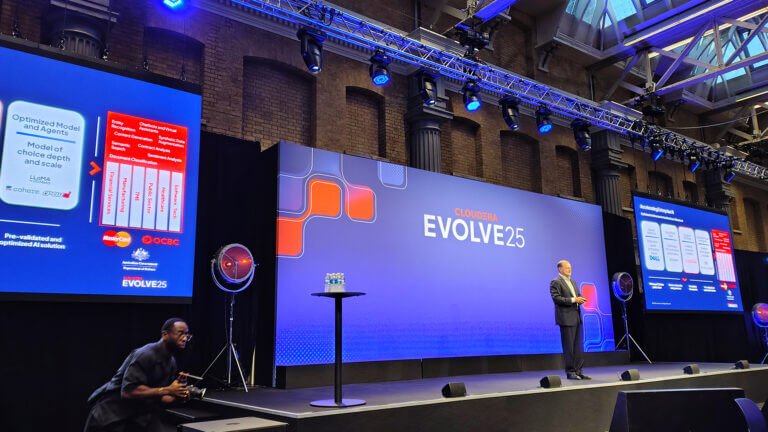

L’espansione dell’intelligenza artificiale nei processi aziendali, nei servizi pubblici e nelle interazioni quotidiane solleva una domanda sempre più urgente: chi controlla i sistemi intelligenti? Se fino a poco tempo fa la risposta standard era “l’uomo”, oggi questa garanzia non appare più sufficiente. A dirlo è Daryl Plummer, Distinguished VP Analyst e Chief of Research di Gartner, che durante il suo intervento al Gartner IT Symposium/Xpo ha descritto l’emergere di una nuova figura: quella dei “Guardian Agents“, agenti digitali autonomi incaricati di garantire il controllo dell’intelligenza artificiale.

Secondo Plummer, è illusorio pensare che gli esseri umani possano continuare a supervisionare ogni istanza o decisione generata da un sistema di AI. La moltiplicazione delle applicazioni e la loro crescente complessità rendono impraticabile l’idea di un “human-in-the-loop” come meccanismo centrale di governance. Gli operatori umani non sono abbastanza numerosi per gestire l’intero volume di output generato e, in molti casi, nemmeno sufficientemente affidabili per farlo con la necessaria coerenza e tempestività.

Indice degli argomenti

Perché gli esseri umani non bastano più

La supervisione umana è stata finora uno dei pilastri dell’adozione etica dell’AI. Ma come sottolinea Plummer, la rapidità con cui i sistemi intelligenti si diffondono e si specializzano supera di gran lunga la capacità delle persone di analizzarne, in tempo reale, il comportamento. Le aziende che vogliono garantire qualità, e sicurezza nei processi automatizzati devono iniziare a delegare parte del controllo ad altri sistemi di AI, progettati per svolgere compiti di supervisione e correzione.

Questa transizione segna un punto di svolta. Non si tratta più di integrare l’intelligenza artificiale nei processi, ma di costruire una metastruttura in cui alcune AI osservano e validano il lavoro di altre. Una condizione che, secondo Plummer, sarà centrale nell’evoluzione futura del controllo dell’intelligenza artificiale.

Sicurezza, osservabilità e orchestrazione automatica

Il concetto di Guardian Agent si colloca all’intersezione tra sicurezza informatica, osservabilità dei sistemi, orchestrazione automatica e gestione del rischio. Gli agenti non sono generalisti: nascono per ruoli specifici, come monitorare l’accuratezza, identificare deviazioni, segnalare errori o comportamenti sospetti.

Plummer sottolinea come i Guardian Agent siano parte di un più ampio ecosistema di agenti specializzati, che include anche mentori e broker. Il loro compito è duplice: proteggere le persone dagli effetti potenzialmente dannosi dell’AI e tutelare la stessa AI dal deterioramento delle sue performance nel tempo. L’obiettivo non è solo contenere, ma anche migliorare la qualità del servizio reso dai sistemi intelligenti.

Cosa stanno già facendo startup come AIXPLAIN

Il modello teorizzato da Gartner trova già applicazioni concrete. Plummer cita il caso di AIXPLAIN, startup che sta sviluppando una gamma di agenti digitali con funzioni di tutoraggio, supporto decisionale e monitoraggio. Tra questi, proprio i Guardian Agents rappresentano la punta più avanzata dell’offerta.

I sistemi proposti da AIXPLAIN non si limitano a osservare i comportamenti delle AI operative, ma sono progettati per agire proattivamente: rilevare anomalie, suggerire modifiche, impedire output inappropriati. In alcuni casi, sono in grado di interrompere l’attività di un sistema se viene superata una soglia critica di rischio o di errore.

La logica è la stessa di un sistema immunitario: riconoscere i segnali di malfunzionamento e intervenire prima che l’intero processo venga compromesso. Una visione che spinge il concetto di controllo dell’intelligenza artificiale oltre la semplice vigilanza passiva.

Oltre il paradosso dell’agente che sorveglia l’agente

Durante la presentazione, Plummer affronta anche una delle obiezioni più classiche: cosa succede quando l’agente che controlla l’intelligenza artificiale diventa a sua volta soggetto a errore? Chi controlla il controllore? La risposta è pragmatica: non serve un regresso infinito di livelli di sorveglianza, perché ogni strato aggiuntivo restringe lo spazio di rischio.

Plummer afferma che in genere bastano uno o due livelli di guardian per ottenere un sistema stabile. La chiave è nella progettazione modulare e nella capacità di ogni agente di operare in base a criteri autonomi ma verificabili. L’obiettivo non è eliminare ogni possibilità di errore, bensì ridurre al minimo l’impatto dei malfunzionamenti e garantire processi più resilienti.

Il futuro dei processi di “auto-guarigione” e autonomia

Guardando al medio termine, l’emergere dei Guardian Agents apre la strada allo sviluppo di sistemi in grado di autoripararsi, riconfigurarsi e adattarsi senza intervento umano. Plummer parla di “sistemi di auto-guarigione” capaci non solo di mantenere l’efficienza operativa, ma anche di evolversi in base a obiettivi definiti dinamicamente.

Questo scenario cambia il ruolo dell’intelligenza artificiale all’interno delle organizzazioni. Non è più solo uno strumento da integrare, ma un ambiente complesso da gestire, con regole, agenti e meccanismi di controllo propri. L’autonomia tecnica si combina con forme di responsabilità distribuita, in cui le decisioni vengono prese da entità artificiali ma monitorate da altri sistemi intelligenti.

Per le imprese tecnologiche, conclude Plummer, questa è l’opportunità per sviluppare nuovi prodotti, servizi e modelli di business. E per i decisori, è l’inizio di una fase in cui le politiche di controllo dell’intelligenza artificiale dovranno essere ripensate da zero.