Il dibattito sull’intelligenza artificiale (AI) e sulla AI generativa (GenAI) è stato già abbastanza dominato da un intenso clamore comunicativo, intriso, per un verso, di scetticismo e preoccupazione per gli impatti sociali ed etici della AI, e, per l’altro, di retorica e roboanti narrative di marketing sulle potenzialità dell’intelligenza artificiale generativa nell’automazione di molti processi aziendali e industriali. Ma ora che questo polverone mediatico denso di contrapposizioni comincia a diradarsi, sembra emergere una consapevolezza più lucida e razionale su ciò che la GenAI può fare o non può fare.

Insomma, il percorso delle varie organizzazioni verso la comprensione e l’adozione della AI nei differenti casi d’uso sembra entrare in una fase più matura.

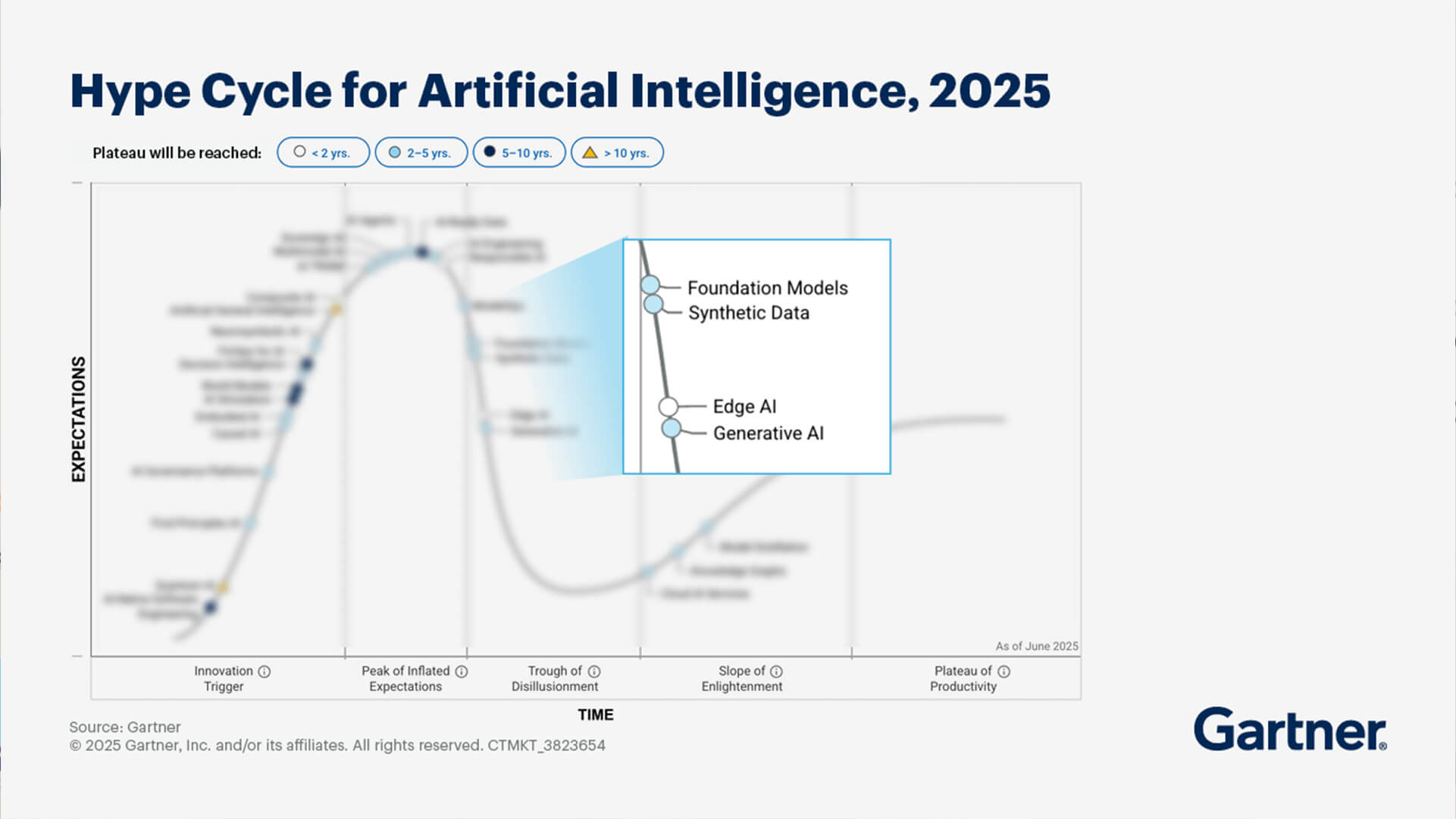

Lo indica il 2025 Hype Cycle for Artificial Intelligence, elaborato dalla società di analisi e consulenza Gartner. Secondo lo studio, grazie ai continui e costanti investimenti nell’intelligenza artificiale e alla sua adozione, le organizzazioni sono passate dalla sperimentazione a un approccio all’AI che si concentra sull’ottenimento di risultati su larga scala e sulle innovazioni fondamentali.

Indice degli argomenti

Difficoltà di governance

Nel 2025, la GenAI entra nella fase che Gartner chiama “trough of disillusionment”, quel periodo di disincanto in cui, svanito l’iniziale entusiasmo, le organizzazioni acquisiscono una maggiore comprensione del potenziale e dei limiti della AI generativa. Per i leader nel campo dell’intelligenza artificiale è comunque ancora difficile dimostrare il valore della GenAI per il business. Nonostante una spesa media di 1,9 milioni di dollari in iniziative GenAI nel 2024, analizza Gartner, meno del 30% degli AI leader riferisce che i propri amministratori delegati sono soddisfatti del ritorno sull’investimento nell’intelligenza artificiale.

Da un lato, le organizzazioni con un basso livello di maturità hanno difficoltà a identificare casi d’uso adeguati e nutrono aspettative irrealistiche riguardo alle iniziative. Dall’altro, le organizzazioni mature faticano a trovare professionisti qualificati, e a diffondere una conoscenza della AI generativa (GenAI literacy) in grado di andare oltre l’uso dei tool per creare risultati di valore, e consentire un utilizzo efficace e responsabile della tecnologia nel contesto aziendale e sociale, considerando implicazioni, rischi e opportunità della GenAI.

In linea generale, le organizzazioni si trovano ad affrontare sfide di governance, tra cui allucinazioni, pregiudizi (bias), imparzialità, e normative governative che possono ostacolare le applicazioni GenAI per la produttività, l’automazione e l’evoluzione dei ruoli lavorativi.

Oltre la GenAI: due tecnologie e paradigmi IT fondamentali

Più abbandonano gradualmente la GenAI come pilastro centrale dei propri programmi AI, più le organizzazioni si concentrano sulle tecnologie che permettono di supportare l’erogazione della AI in maniera sostenibile. In particolare, Gartner identifica due tecnologie e paradigmi IT chiave per semplificare l’integrazione e la gestione dei sistemi AI, e renderli più efficaci ed espandibili.

Uno è l’ingegneria della AI (AI engineering), disciplina che si focalizza su progettazione, sviluppo e implementazione di sistemi AI in maniera coerente e sicura, consentendo di fornire soluzioni AI e GenAI su scala aziendale. L’altro è il framework ModelOps, che si concentra sulla governance completa e sulla gestione del ciclo di vita della AI e dei modelli decisionali, standardizzando, espandendo e portando in produzione i progetti AI e GenAI.

Nella transizione verso queste due fondamentali tecnologie, un ulteriore supporto, secondo Gartner, quest’anno proviene da altri due principali motori, ossia i dati AI-ready (AI-ready data) e gli agenti AI. I primi derivano da pratiche evolute di gestione dei dati, che servono a renderli idonei all’utilizzo per specifici casi d’uso della AI, evitando di fallire gli obiettivi aziendali. Gli agenti AI, invece, permettono essenzialmente di eseguire compiti complessi, contribuendo a trasformare e innovare i modelli di business.

Limiti della AI generativa, senza affidabilità non esiste vera automazione

La cosiddetta “allucinazione” a cui la AI generativa può essere soggetta, ossia la creazione di una risposta, di un’informazione falsa, o priva di senso, o imprecisa, ma presentata come fatto plausibile, non è un’anomalia correggibile. Piuttosto è un sottoprodotto indesiderato ma ineludibile, derivante dalla natura stessa del modello linguistico di grandi dimensioni (LLM), che è una macchina statistica e probabilistica. Le allucinazioni, scrive in un post su Linkedin Walter Quattrociocchi, professore ordinario di informatica alla Sapienza Università di Roma, “non sono un malfunzionamento: sono una proprietà del sistema”.

Di conseguenza, chiarisce, in assenza di affidabilità della risposta non è possibile implementare una vera automazione, quindi delegare determinati compiti umani all’intelligenza artificiale. Insomma, aggiungiamo noi, di una AI siffatta, priva di una reale capacità di comprensione, non ci si può fidare. Ad esempio, basterebbe ricordare il fallito esperimento di “automated order taking” (AOT) avviato nel 2021 da McDonald’s in collaborazione con IBM. La prova è terminata nel 2024, dopo troppi fraintendimenti della AI, ordinazioni errate, ed episodi comici, tra cui il gelato ricoperto di bacon, divenuti virali sui social.

Gestire i rischi generati dalla AI

In settori altamente specializzati e regolamentati, come la sanità, il banking, il mondo assicurativo, risposte imprecise o errate della GenAI possono costare care. Risultano dunque inaccettabili, per le implicazioni possibili, e i rischi connessi a livello di sicurezza fisica (safety), qualità dei contenuti, protezione dei dati.

Considerando che i modelli avanzati di intelligenza artificiale sono destinati a diventare strumenti indispensabili per gli amministratori delegati, scrive Boston Consulting Group (BCG), e che nell’arco di cinque anni potrebbero supportare più di un quarto delle responsabilità di un Ceo, per sbloccare in modo sicuro il valore della AI, queste figure manageriali dovranno combinare una leadership visionaria con una solida capacità di gestione del rischio.

Per accelerare le trasformazioni guidate dalla AI i manager dovrebbero quindi affidarsi alle proprie funzioni risk & compliance (R&C). In tutti i settori, ricorda BCG, la gestione del rischio e della conformità gioca infatti un ruolo fondamentale nella definizione delle linee guida per stabilire una strategia AI che sia in grado di bilanciare risultati e rischi.