L’adozione dell’AI generativa sta accelerando in ogni settore ma l’AI security non cresce con la stessa rapidità. Questo perché la maggior parte dei progetti di intelligenza artificiale nasce per innovare, non per proteggersi. Ed è questo divario che apre nuove superfici di rischio. A confermarlo i dati: il 97% delle organizzazioni che ha segnalato una violazione di dati connessa all’AI erano prive di misure di controllo, mentre il 63% non ha policy di governance per gestire l’AI o prevenire attacchi annessi alla shadow AI (fonte: “IBM Cost of a Data Breach Report 2025”). Ciò significa che le aziende si stanno muovendo su un terreno scoperto, dove la velocità dell’innovazione supera la capacità di presidio.

«L’intelligenza artificiale nasce per apprendere, e per farlo ha bisogno di accedere a tutto il know-how aziendale: documentazione, dati, contenuti, senza alcun privilegio o filtro il che significa apertura totale – spiega Luca Di Muccio, Data Security Brand Sales Specialist di IBM Technology -. L’Al tempo stesso è un sistema il cui l’output è, per definizione, impredicibile. Dare in pasto tutti i dati senza controlli a qualcosa che può generare risultati imprevisti è un rischio enorme. Le vulnerabilità connesse all’intelligenza artificiale sono di varia natura e di diversa provenienza. Ci sono quelle di business, quelle legate all’input e quelle legate all’output dei modelli. Pensiamo a dati sensibili che finiscono nei dataset di training, o a modelli che generano risposte non corrette o inopportune. Serve una consapevolezza nuova dei punti di esposizione, perché la superficie d’attacco dell’AI è già oggi molto più ampia di quanto le aziende percepiscano».

Indice degli argomenti

Dal framework globale al progetto locale

Il presidio, come indicano anche le linee guida del NIST Risk Management Framework, deve essere strutturato in modo proattivo: dalla progettazione delle pratiche di prompt engineering alla validazione dei dati in input, fino al monitoraggio continuo di possibili attività malevole. Garantire la sicurezza dei prompt significa estendere la protezione all’interfaccia linguistica dell’AI, prevenendo manipolazioni e assicurando che i sistemi operino in modo controllato, sicuro ed etico. La vera sfida, però, è trasformare questi principi in pratiche operative, adattandoli ai contesti e alle architetture delle imprese. È qui che i partner emergono come figure chiave, chiamati a integrare linee guida e strumenti all’interno delle architetture e delle priorità di ciascuna organizzazione. La sfida non è applicare un modello, ma adattarlo dentro i confini, i dati e le regole del contesto aziendale.

«Il lavoro dei partner è fondamentale perché la sicurezza dell’AI non è una tecnologia che si installa, ma un ecosistema che si costruisce – sottolinea Di Muccio -. Ogni impresa ha un diverso grado di maturità, una diversa esposizione ai rischi e una propria velocità di adozione. Per questo servono competenze capaci di interpretare i framework, declinarli e mantenerli vivi nel tempo».

In questo scenario si inserisce Italware, IBM Platinum Partner e parte del Gruppo Digital Value, che porta nella relazione con IBM una potenza di fuoco consolidata nella gestione di infrastrutture critiche, data protection e compliance, trasformando linee guida e metodologie globali in progetti concreti. Con una presenza capillare sul territorio italiano e competenze specialistiche in ambito sicurezza e governance dei dati, Italware rappresenta quell’ultimo miglio tra la visione globale di IBM e le esigenze concrete delle imprese.

Dati e modelli: la doppia vulnerabilità dell’AI

È fondamentale capire come i sistemi di AI espongono un duplice livello di vulnerabilità. A monte, nella fase di training, la qualità e la provenienza dei dati possono compromettere l’integrità dei modelli. A valle, nell’uso quotidiano, ogni interazione con gli utenti diventa potenzialmente un vettore d’attacco. Gli analisti fotografano l’emergere di un perimetro di rischio del tutto nuovo, dove i modelli diventano a loro volta bersagli. Dalle manipolazioni linguistiche agli attacchi ai dataset, la superficie d’attacco dell’AI si estende su livelli mai esplorati prima.

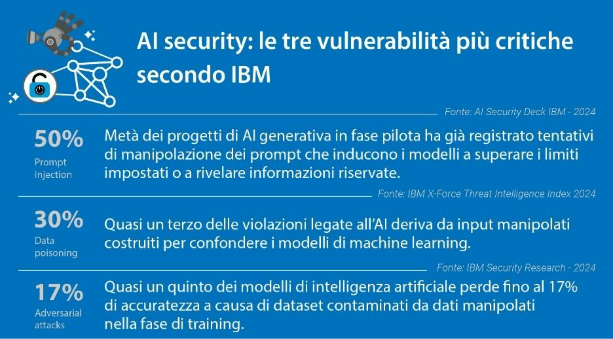

- Metà dei progetti di AI generativa in fase pilota monitorati da IBM ha già registrato tentativi di prompt injection. Questo tipo di attacco sfrutta il linguaggio naturale per spingere il modello oltre i limiti impostati, inducendolo a rivelare informazioni riservate o a generare contenuti non conformi. È la nuova frontiera della manipolazione applicativa, che trasforma la conversazione stessa in un vettore d’attacco.

- Gli adversarial attacks, invece, ingannano il sistema con dati alterati in modo impercettibile, inducendolo a generare risposte errate o incoerenti senza lasciare tracce nei log. È una minaccia subdola perché agisce sotto soglia, minando l’affidabilità dei risultati e la fiducia negli algoritmi.

- Il data poisoning introduce informazioni manipolate nella fase di addestramento, falsando la conoscenza che l’AI costruisce e producendo bias difficili da individuare. La minaccia colpisce a monte, compromettendo l’integrità dei dati su cui si fonda ogni decisione automatizzata.

«L’OWASP (Open Worldwide Application Security Project) – puntualizza Di Muccio -, un’organizzazione no profit internazionale che sviluppa e diffonde standard di sicurezza per il software, nel 2025 ha pubblicato l’ultima edizione del report “Top 10 Risk & Mitigations” dedicato specificamente agli LLM and Generative AI Applications, identificando il prompt injection al primo posto tra i rischi emergenti. È fondamentale avere sistemi che controllino i prompt sia in input sia in output, verificando che non contengano contenuti sensibili o impropri e che non producano risposte confidenziali».

Governance e AI security: come costruire fiducia nei sistemi intelligenti

Con l’AI separare la security dalla governance non è più possibile. La tecnologia, infatti, mette in relazione dati, modelli e processi decisionali, rendendo indistinguibili la dimensione del controllo e quella della protezione. Ogni decisione automatizzata, ogni correlazione generata da un modello o risposta fornita da un agente AI diventa parte del perimetro di sicurezza aziendale. Garantire trust e accountability non significa più solo proteggere l’infrastruttura, ma assicurare che l’AI operi in modo trasparente, tracciabile e conforme. In questo scenario, la sicurezza non è più una funzione di difesa, ma un elemento costitutivo della governance dei modelli.

È su questa visione che IBM ha costruito una strategia integrata che estende la protezione dal dato al modello, fino al comportamento dei sistemi intelligenti. Un approccio unitario all’AI Security che consente alle imprese di sviluppare innovazione senza rinunciare al controllo.

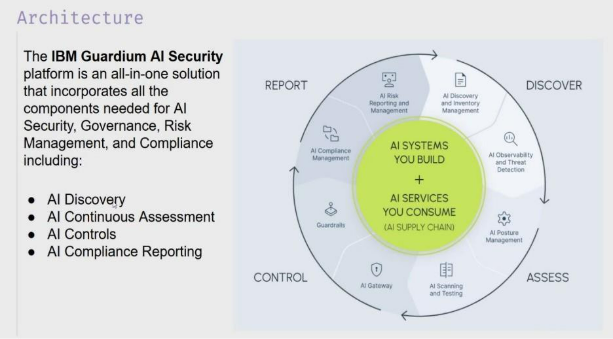

«IBM Watsonx.governance e IBM Guardium AI Security sono due componenti di un’unica strategia – puntualizza Di Muccio -. La prima presidia la parte di controllo, tracciabilità e auditabilità dei modelli: consente di sapere da dove arrivano i dati, come vengono utilizzati, chi modifica i modelli e con quali criteri. La seconda si concentra sulla protezione in esercizio, monitorando i comportamenti dei modelli e verificandone la conformità rispetto agli standard di sicurezza. Insieme, le due soluzioni coprono l’intero ciclo di vita dell’AI, dalla costruzione al deployment. È questo il punto: l’AI Security non è un’aggiunta a valle, ma un’estensione della governance. Significa progettare l’intelligenza artificiale in modo sicuro fin dall’inizio, perché solo un’AI che possiamo controllare, spiegare e proteggere è un’AI affidabile».

Dal rischio alla postura di sicurezza

Rispetto alla postura della sicurezza informatica, l’AI sposta il focus. Non basta sapere quali asset esistono e come sono configurati (infrastrutture, modelli, pipeline). Conta che cosa il modello apprende, da dove lo apprende, con quale frequenza viene aggiornato e quali vincoli o integrazioni ne condizionano il comportamento. Il perimetro si allarga ai training data e alla loro provenienza, alle pipeline MLOps e alle dipendenze (RAG, vector DB, API), ai prompt e agli output in linguaggio naturale, fino al grado di autonomia degli agenti.

«La protezione di un sistema di AI non si esaurisce con un controllo una tantum – fa notare Di Muccio -. È un processo iterativo che si articola in quattro fasi: discovery, assessment, controllo e reportistica. La discovery è la fase della consapevolezza: capire che cosa devo proteggere, dove si trovano i modelli, chi li usa e con quali dati. Non è banale, perché spesso scopriamo l’esistenza di shadow AI, soluzioni implementate senza che l’IT ne sia a conoscenza o le abbia autorizzate. Rappresentano un perimetro non protetto, e la piattaforma Guardium AI Security nasce anche per individuare questi casi e censirli. In questa fase il monitoraggio continuo dei modelli è essenziale anche per la rilevazione tempestiva di eventuali minacce, anomalie o tentativi di compromissione».

Come racconta il manager, una volta completata la discovery si passa all’assessment, cioè alla valutazione della sicurezza. Qui entrano in gioco il posture management e la validazione proattiva della sicurezza dei modelli: verifichiamo quanto gli asset sono protetti prima che qualcuno tenti di violarli, rileviamo eventuali vulnerabilità o misconfigurazioni, accertiamo con test di penetrazione automatizzati la resilienza a prompt injection o input manipolati e produciamo un report che descrive in modo puntuale lo stato dell’infrastruttura.

«Il controllo dei prompt in input e in output è altrettanto essenziale – dice Di Muccio -. Significa intercettare comandi malevoli, tentativi di prompt injection o richieste inopportune, ma anche evitare che il modello esponga informazioni confidenziali o proprietarie. A tutto questo aggiungiamo dei guard-rail, cioè limiti operativi che definiscono che cosa il modello può o non può fare. Solo così è possibile avere una postura di sicurezza stabile e verificabile nel tempo».

Competenze e consapevolezza: la Agentic AI Academy

L’AI non è una tecnologia allo stato solido, ma un sistema in trasformazione continua che obbliga imprese e professionisti a rimanere in apprendimento permanente. L’AI security, dunque, richiede una competenza dinamica, capace di adattarsi al cambiamento: ogni nuova generazione di modelli apre scenari inediti, introduce superfici di rischio diverse e impone un aggiornamento costante delle conoscenze.

«La sicurezza dell’AI è anche una questione culturale – conclude Di Muccio –. IBM su questo fronte sta investendo nel rafforzamento delle competenze condivise, supportando partner e clienti con percorsi di formazione, strumenti di valutazione e framework comuni. Con i seminari di Agentic AI Academy, replicati nelle diverse regioni e ricorrenti, abbiamo voluto rendere questo approccio concreto, favorendo la nascita di un linguaggio unificato tra governance e security: solo una conoscenza diffusa può trasformarsi in controllo effettivo. Solo attraverso una formazione continua e collaborativa sarà possibile far evolvere la protezione dei dati in una nuova forma di responsabilità digitale, capace di tenere il passo con l’intelligenza che cambia».

L’edizione EMEA 2025 dell’Agentic Academy appena conclusa a Roma, è stata dedicata proprio a questi temi: come costruire fiducia nei sistemi intelligenti, integrare la sicurezza nella governance e trasformare la conoscenza in una competenza diffusa.